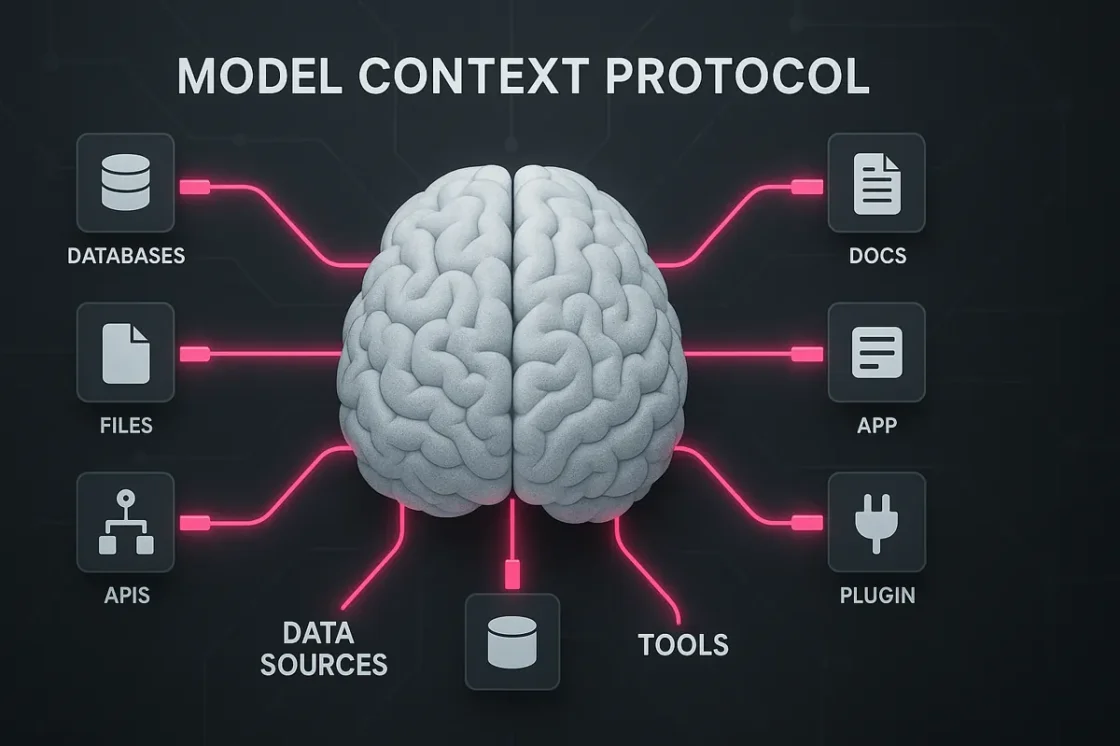

Das Model Context Protocol (MCP) verändert grundlegend die Art und Weise, wie KI-Systeme mit externen Datenquellen und Tools kommunizieren. Als universeller Standard zur Verbindung von KI-Modellen mit verschiedenen Systemen verspricht MCP eine neue Ära der nahtlosen Integration und erweiterten Funktionalität für KI-Anwendungen. Dieser Artikel erklärt, was MCP ist, wie es funktioniert und warum es für die Zukunft der KI-Integration so bedeutsam ist.

Das Model Context Protocol, kurz MCP, ist ein offener Protokollstandard, der von Anthropic Ende 2024 eingeführt wurde. Es standardisiert die Art und Weise, wie KI-Anwendungen und Large Language Models (LLMs) mit externen Datenquellen, Tools und Systemen interagieren. MCP lässt sich am besten als „USB-C-Anschluss für KI-Anwendungen“ beschreiben – ein universeller Konnektor, der es KI-Modellen ermöglicht, sich mit verschiedenen Datenquellen und Werkzeugen auf konsistente Weise zu verbinden.

Die grundlegende Idee hinter MCP ist die Lösung eines fundamentalen Problems: Bisher mussten Entwickler für jede Kombination aus KI-Anwendung und externer Datenquelle oder Tool eine eigene, maßgeschneiderte Integration über individuelle APIs programmieren. Dies führte zu einem „M×N-Problem“, bei dem M verschiedene KI-Anwendungen mit N verschiedenen externen Systemen verbunden werden mussten, was zu enormem Entwicklungsaufwand führte.

MCP transformiert dieses Problem in ein „M+N-Problem„, indem es eine standardisierte Schnittstelle zwischen KI-Modellen und externen Systemen bietet. Dadurch müssen Entwickler nur noch einmal eine MCP-konforme Schnittstelle für ihre Anwendung oder ihr Tool erstellen, anstatt für jede Kombination eine eigene Integration zu entwickeln.

Das sogenannte „M×N-Problem“ ist eine der größten Herausforderungen in der KI-Integration: Wenn M verschiedene KI-Anwendungen mit N verschiedenen Datensystemen verbunden werden müssen, entstehen potenziell M×N individuelle Integrationen, die alle separat entwickelt und gewartet werden müssen. Mit jedem neuen System oder jeder neuen KI-Anwendung steigt der Entwicklungsaufwand exponentiell an – ein unhaltbarer Zustand für komplexe Technologieumgebungen.

Die MCP-Architektur folgt einem Client-Server-Modell und besteht aus drei Hauptkomponenten:

Dies sind die Anwendungen, mit denen Benutzer direkt interagieren, wie z.B. Claude Desktop, KI-unterstützte IDEs wie Cursor oder andere KI-Assistenten, die bei der Content-Erstellung helfen. Der Host dient als primäre Schnittstelle für KI-Funktionalität und steuert das Gesamtsystem.

Die Clients sind in der Host-Anwendung integriert und verwalten die Verbindungen zu MCP-Servern. Jeder Client unterhält eine 1:1-Beziehung zu einem Server und sorgt für die Kommunikation zwischen Host und Server. Die Clients übersetzen zwischen den Anforderungen des Hosts und dem Model Context Protocol.

Dies sind leichtgewichtige Programme, die spezifische Fähigkeiten über das standardisierte MCP bereitstellen. Server können lokale Datenquellen (wie Dateien auf dem Computer) oder Remote-Services (wie GitHub, Slack oder Datenbanken) zugänglich machen. Sie bieten drei Arten von Funktionalitäten:

Der grundlegende Ablauf einer MCP-Integration folgt einem strukturierten Prozess:

Diese standardisierte Kommunikation ermöglicht eine nahtlose Integration zwischen KI-Modellen und externen Systemen ohne komplexe, maßgeschneiderte Implementierungen für jede Kombination.

Im Vergleich zu herkömmlichen API-Integrationen bietet MCP mehrere entscheidende Vorteile:

Während jede API ihre eigenen Konventionen, Authentifizierungsmethoden und Datenformate haben kann, bietet MCP einen einheitlichen Standard für alle Integrationen. Dies vereinfacht die Entwicklung erheblich und reduziert den Integrationsaufwand.

MCP ermöglicht es KI-Modellen, verfügbare Tools dynamisch zu entdecken und zu nutzen. Anstatt auf einen vordefinierten Satz von Funktionen beschränkt zu sein, kann eine KI mit MCP zur Laufzeit nach verfügbaren Tools fragen und entscheiden, wie sie diese basierend auf dem aktuellen Kontext nutzen will.

MCP unterstützt persistente, bidirektionale Kommunikation in Echtzeit, ähnlich wie WebSockets. Dies ermöglicht kontinuierliche Interaktionen und Kontextupdates im Gegensatz zu den einmaligen, abgeschlossenen Anfragen traditioneller REST-APIs, deren Bedeutung im API-Report 2024 untersucht wurde.

Durch die Entkopplung des KI-Modells von den Datenquellen kann jede Komponente unabhängig skaliert oder aktualisiert werden. Benötigen Sie eine neue Datenquelle? Starten Sie einfach einen neuen MCP-Server dafür, ohne die Kernlogik Ihrer KI-Anwendung zu verändern.

Das Model Context Protocol eröffnet eine Vielzahl von Anwendungsmöglichkeiten, die die Funktionalität und Leistungsfähigkeit von KI-Assistenten deutlich erweitern:

Mit MCP kann ein KI-Assistent wie Claude auf aktuelle Informationen zugreifen, die über seinem Wissensstichtag liegen. Anstatt veraltete oder ungenaue Antworten zu geben, kann der Assistent über MCP-Server auf die neuesten Daten zugreifen.

Entwicklungsumgebungen wie Cursor oder Zed können MCP nutzen, um KI-Assistenten mit Dateisystemen, Versionskontrolle, Paketmanagern und Dokumentation zu verbinden. Dies ermöglicht kontextreichere und funktionalere Codevorschläge.

Unternehmen können MCP-Server für ihre internen Systeme wie Datenbanken, CRMs oder Dokumentenverwaltungssysteme erstellen. Dies ermöglicht es KI-Assistenten, auf unternehmensspezifische Daten zuzugreifen und fundiertere Antworten zu geben, ähnlich wie moderne KI-Assistenten wie manubes den Datenzugriff in der Produktion verbessern.

Durch die Kombination mehrerer MCP-Server können komplexe, agentenbasierte Workflows erstellt werden. Ein Benutzer könnte beispielsweise bitten, „überprüfe lokale Fehlerprotokolle und sende relevante Issues an Slack“, wobei der KI-Agent mehrere MCP-Server koordiniert, um diese Aufgabe auszuführen.

Mehrere Unternehmen und Projekte haben bereits begonnen, MCP zu implementieren und in ihre Produkte zu integrieren:

Anthropic’s Claude Desktop App war eine der ersten Anwendungen mit MCP-Unterstützung. Benutzer können lokale MCP-Server verbinden, um Claude Zugriff auf lokale Dateien, GitHub-Repositories oder andere Datenquellen zu geben.

Microsoft hat MCP-Unterstützung in Copilot Studio integriert, was es Entwicklern ermöglicht, KI-Apps und -Agenten mit nur wenigen Klicks hinzuzufügen. Über MCP werden Aktionen und Wissen automatisch zum Agenten hinzugefügt und aktualisiert, wenn sich die Funktionalität weiterentwickelt, wobei aktuelle Trends im Bereich der Embedded-KI berücksichtigt werden.

Die Cursor IDE, eine auf KI-Unterstützung spezialisierte Entwicklungsumgebung, nutzt MCP, um Kontextinformationen aus Codebases zu extrahieren und dem KI-Modell bereitzustellen, was zu präziseren und nützlicheren Codevorschlägen führt.

DataCamp demonstrierte die Entwicklung eines MCP-Servers, der GitHub mit Claude verbindet, um Pull Requests automatisch zu analysieren. Der Server ermöglicht es Claude, PR-Details abzurufen, Code zu analysieren und Ergebnisse in Notion zu speichern.

Während MCP-Implementierungen in verschiedenen Branchen zunehmen, ist es wichtig zu beachten, dass die offizielle MCP-Dokumentation auf modelcontextprotocol.io kontinuierlich aktualisiert wird und umfassende Informationen für Entwickler bereitstellt, die mit der Integration beginnen möchten.

Die Einführung des MCP bietet eine Reihe von Vorteilen für das gesamte KI-Ökosystem:

Da das Modell leicht auf die benötigten Informationen zugreifen kann, kann es genauere, kontextreichere Antworten liefern. Frühe Anwender haben festgestellt, dass KI-Assistenten mit direktem Zugang zu relevanten Daten (über MCP) nuanciertere und korrektere Outputs liefern.

Entwickler müssen keine individuellen Integrationen mehr für jede Kombination aus KI-Modell und Datenquelle erstellen. Durch die Standardisierung werden Entwicklungszeit und -kosten erheblich reduziert.

Durch die Entkopplung des KI-Modells von den Datenquellen kann jede Komponente unabhängig skaliert oder aktualisiert werden. Diese modulare Architektur erleichtert die Verwaltung komplexer KI-Workflows und ermöglicht es, neue Funktionalitäten wie Lego-Bausteine zusammenzusetzen.

MCP wurde mit Blick auf Sicherheit entwickelt. Das Protokoll unterstützt die Beibehaltung von Daten innerhalb der eigenen Infrastruktur und den Austausch von Daten nur über kontrollierte Kanäle. Dies bedeutet, dass sensible Informationen nicht den Servern des KI-Anbieters ausgesetzt werden müssen.

Trotz seiner Vorteile steht MCP noch vor einigen Herausforderungen:

Das Protokoll selbst spezifiziert nicht im Detail, wie Authentifizierung behandelt werden sollte, was zu inkonsistenten Sicherheitspraktiken führen kann. Das MCP-Team arbeitet jedoch an Verbesserungen in diesem Bereich.

Als relativ neues Protokoll verfügt MCP noch nicht über ein so umfangreiches Ökosystem wie etablierte Integrationsstandards. Es gibt weniger Server, und viele Anwendungen haben noch keine offiziellen MCP-Server.

In Umgebungen mit hohem Durchsatz könnte die ständige Serialisierung/Deserialisierung und der Kontextwechsel zwischen Systemen zu einem Engpass werden, wenn sie nicht ordnungsgemäß optimiert sind.

Es besteht das Risiko einer Fragmentierung, wenn mehrere konkurrierende Standards entstehen. Proprietäre Erweiterungen zu MCP könnten zu Vendor Lock-in führen und die Flexibilität von Implementierungen einschränken.

Als offener Standard wird MCP weiterentwickelt und verbessert. Die jüngsten Updates im März 2025 umfassen:

Das Protokoll integriert jetzt das OAuth 2.1-Framework für die Authentifizierung von Remote-HTTP-Servern, was die Sicherheit der MCP-Verbindungen erhöht.

Der frühere HTTP+SSE-Transport wird durch einen flexibleren Streamable HTTP-Transport und Unterstützung für JSON-RPC-Batching ersetzt, was die Effizienz der Kommunikation verbessert.

Neue Tool-Annotationen bieten mehr Metadaten über das Verhalten eines Tools (z.B. schreibgeschützt vs. destruktiv), was eine feinere Kontrolle über die Tool-Interaktionen ermöglicht.

Das Model Context Protocol (MCP) stellt einen bedeutenden Fortschritt in der Art und Weise dar, wie KI-Systeme mit externen Datenquellen und Tools interagieren. Durch die Standardisierung dieser Interaktionen vereinfacht MCP die Entwicklung kontextbewusster KI-Anwendungen und ermöglicht eine tiefere Integration zwischen KI-Modellen und den Systemen, die sie unterstützen.

Als offener Standard mit wachsender Unterstützung von großen Technologieunternehmen wie Anthropic und Microsoft hat MCP das Potenzial, die Zukunft der KI-Integration zu prägen. Für Entwickler, die KI-gestützte Anwendungen wie LLMoin für die öffentliche Verwaltung erstellen, bietet MCP eine effizientere und flexiblere Möglichkeit, KI-Modelle mit den benötigten Daten und Funktionen zu verbinden.

Die kommenden Jahre werden zeigen, wie sich MCP weiterentwickelt und ob es sein Versprechen einlösen kann, die „USB-C-Schnittstelle für KI“ zu werden – ein universeller Standard, der die Komplexität der KI-Integration reduziert und neue Möglichkeiten für innovative KI-Anwendungen eröffnet.

Um Ihnen ein optimales Erlebnis zu bieten, verwenden wir Technologien wie Cookies, um Geräteinformationen zu speichern und/oder darauf zuzugreifen. Wenn Sie diesen Technologien zustimmen, können wir Daten wie Ihr Surfverhalten oder eindeutige IDs auf dieser Website verarbeiten. Wenn Sie Ihre Zustimmung nicht erteilen oder widerrufen, können bestimmte Merkmale und Funktionen beeinträchtigt werden.