Notion-Template für Abschlussarbeiten: Was ich in 8 Wochen über KI und Tool-Entwicklung gelernt habe. Von blindem Vertrauen in plausible Antworten über technische Schuld bis zur robusten Lösung – ein ehrlicher Rückblick auf Erfolge, Sackgassen und die zentrale Rolle von Fachexpertise.

Einstieg: Der Traum vom „einfach machen lassen“

Ausgangspunkt war ein YouTube-Impuls und die Idee, mein erprobtes Coaching-Wissen zu wissenschaftlichen Abschlussarbeiten in ein Notion-Template zu übersetzen. Statt „einmal fragen, fertig“ wählte ich einen methodischen Aufbau: Zuerst ein Meta-Agent zur sauberen Anforderungsaufnahme (Zielgruppe, Phasenmodell, Verlinkung von Lernressourcen), daraus ein spezialisierter Notion-Agent. In TypingMind arbeitete ich modellübergreifend und bat um eine Timeline, die Phasen, Meilensteine und Aufgaben abbildet.

Die Antwort war komplexer als erwartet: verknüpfte Datenbanken, Relations, Rollups, Formeln. Der entscheidende Gedanke folgte schnell: Nutzer:innen sollen nur Projektnamen sowie Start- und Enddatum eingeben; der Rest wird automatisch generiert. Die meisten Templates sind leere Hüllen – dieses sollte eingebautes Praxiswissen liefern.

Acht Wochen später standen sechs verknüpfte Datenbanken, über 50 Formeln und drei spezialisierte Agenten. Dazwischen lagen Sackgassen, aufgeräumte Chaos-Spuren und eine zentrale Einsicht: KI beschleunigt, ersetzt aber weder Fachexpertise noch methodische Validierung. Was funktionierte, was scheiterte und welche Regeln sich daraus ableiten lassen, zeigt dieser Bericht.

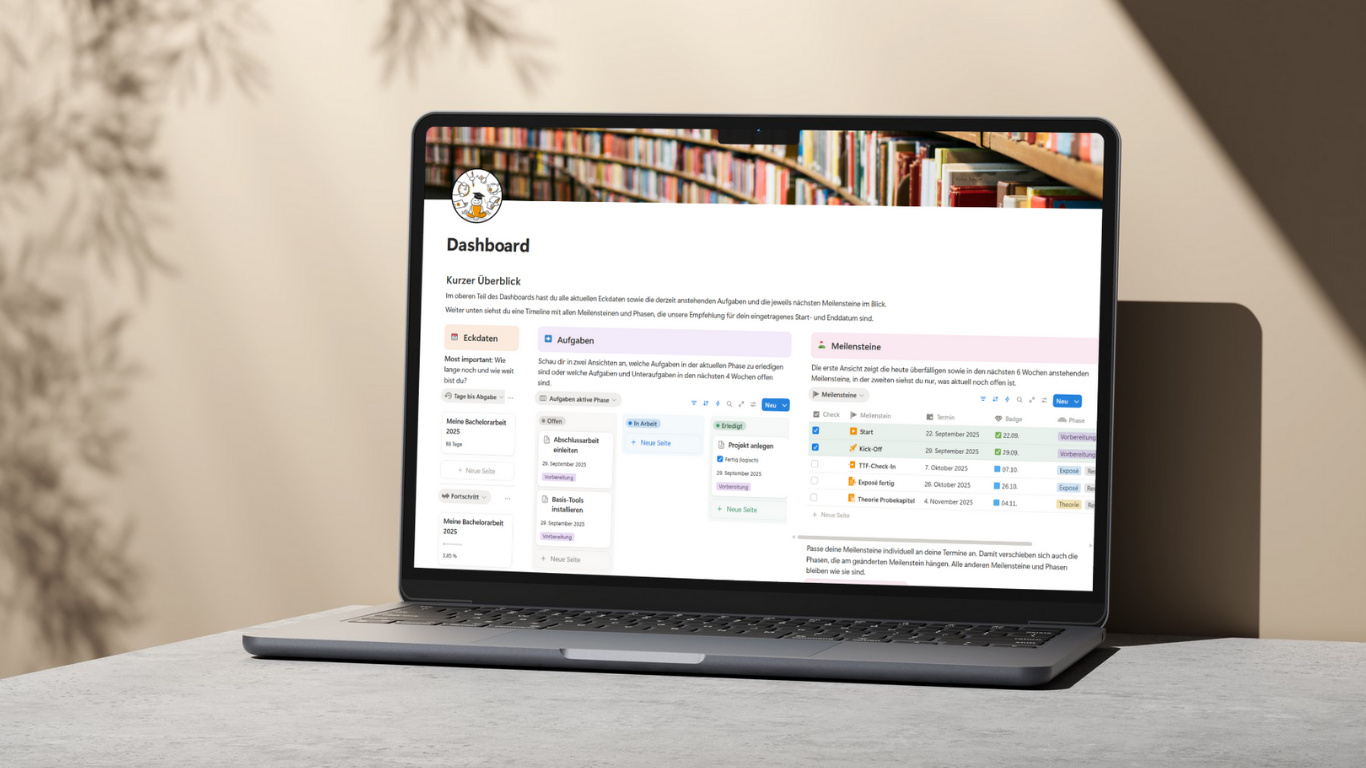

Das Projekt: Ein Dashboard, das mitdenkt

Ziel war ein Dashboard, das aus Start- und Abgabedatum einen realistischen, anpassbaren Fahrplan erzeugt. Statt starrer „Woche 1–4/5–8“-Schablonen berechnet das System Dauer und Reihenfolge automatisch und zeigt auf einer Seite Restzeit, Fortschritt, aktuelle Aufgaben und anstehende Meilensteine. Die Timeline visualisiert acht Phasen – von Vorbereitung über Exposé, Recherche, Theorie, Empirie und Analyse bis Abschluss und Puffer – sowie zehn Meilensteine vom Start bis zur Abgabe. Kernnutzen sind klar formulierte Aufgaben mit Unteraufgaben, kompakten Hinweisen aus der Coaching-Praxis und Verweisen auf passende Ressourcen. Aus abstrakten Überschriften wird so ein handhabbarer Arbeitsplan.

Technisch wird das Template von sechs verknüpfte Datenbanken (Projekt, Phasen, Meilensteine, Schedule für die Timeline, Aufgaben, Unteraufgaben) mit Formeln und Rollups für Terminierung, Fortschritt und Filterlogik getragen. Die eigentliche Komplexität lag im Inhalt: sinnvolle Phasen, belastbare Meilensteine, über 40 Aufgaben in einer robusten Reihenfolge, inklusive typischer Dauerrelationen. Genau hier floss die Erfahrung aus der Begleitung zahlreicher Abschlussarbeiten ein; die KI half vor allem bei der Übersetzung dieser Logik in Notion.

Quelle: WeKnow Studienwerkstatt / YouTube.com

Der KI-Setup: Wie ich methodisch vorgegangen bin

Ein einzelner, immer länger werdender Chat erwies sich schnell als unbrauchbar. Stattdessen arbeitete ich mit präzise konfigurierten Agenten, kurzen Iterationen und regelmäßigen Resets. Ein Meta-Agent strukturierte Anforderungen und Grenzen; der Notion-Agent lieferte Strukturen und Formeln; ein zweiter, kritischer Agent hinterfragte Annahmen systematisch: Was funktioniert in Notion tatsächlich? Welche Limitierungen sind bekannt? Wo drohen Edge Cases?

TypingMind ermöglichte den Wechsel zwischen Modellen im laufenden Kontext: ein starkes Modell wie GPT-5 für komplexe Logik, leichtere Gemini-Varianten für schnelle Checks, ergänzend ein Anthropic-Textmodell für bessere Mikrotexte in Erklärungen. Entscheidend war, Informationen strukturiert zu übergeben. CSV-Exporte statt Freitext reduzierten Missverständnisse bei Property-Typen und Verknüpfungen; Screenshots machten Ansichten, Filter und Layouts auf einen Blick klar. Multi-Modell-Validierung verhinderte, dass plausible, aber unbrauchbare Lösungen unbemerkt in die Architektur wandern. So entstand kein „magisches Prompting“, sondern ein reproduzierbarer Prozess: klare Rollen, kurze Validierungszyklen, strukturierte Inputs und ein eingeplanter Gegencheck.

Die Achterbahn: Vom schnellen Erfolg zur schleichenden Ernüchterung

Die ersten Tage nach dem Startschuss wirkten verheißungsvoll: Der Notion-Agent schlug tragfähige Strukturen vor, die ersten Formeln griffen, der Fortschritt war sichtbar – die Zeitplanung optimistisch. Mit wachsender Komplexität veränderte sich das Bild. Antworten wurden generischer, bestehende Elemente gerieten im Chat in Vergessenheit, Formeln mussten laufend angepasst werden.

Das erste Learning: Lange Chats sind bei komplexen Projekten kontraproduktiv; kürzere Sessions mit klaren Zielen, Resets und Modellwechseln sind stabiler.

Der erste harte Bruch folgte bei der Nutzereingabe: Start- und Enddatum über ein Formular schien elegant, funktionierte in Kombination mit Datenbankvorlagen aber nicht. Stunden Arbeit endeten ohne tragfähige Umsetzung.

Das zweite Learning: „Plausibel“ ist nicht gleich „umsetzbar“ – Tool-Limits setzen die Grenze, nicht die Rhetorik der KI.

Der Neustart mit frischem Kontext und einem anderen Modell brachte Notion Buttons ins Spiel. Der „Monster-Button“ legte fortan Phasen, Meilensteine und Schedule-Einträge automatisch an.

Das dritte Learning: Modellwechsel und Resets öffnen Lösungsräume, die ein überfrachteter Chat verbaut.

Parallel wuchs technische Schuld: Experimente hinterließen verwaiste Properties, Relations und Rollups. Ein halber Tag Refactoring war nötig, um Fehlerquellen zu schließen.

Das vierte Learning: Aufräumen gehört in den Plan – spätestens nach größeren Umbauten.

Der nächste Dämpfer: Eine verlinkte Datenbank sollte Updates in duplizierten Templates sichtbar machen. In der Praxis ließ sie sich nicht passend filtern und erschien in Duplikaten nicht. Ergebnis war ein schlichter Link – weniger elegant, aber robust.

Das fünfte Learning: Früh auf kleinem Scope validieren, bevor „schöne“ Lösungen skaliert werden.

Ab diesem Zeitpunkt lief immer ein kritischer Agent mit: bekannte Notion-Limitationen, geplante Features, potenzielle Edge Cases.

Das sechste Learning: Kreativer Agent plus kritischer Gegenpart reduziert Sackgassen und schärft Erwartungen.

Was KI kann – und was nicht

KI ist ein starker Assistent. Sie schlägt in Sekunden tragfähige Strukturen vor, erklärt Formeln verständlich, denkt Varianten mit und beschleunigt Iterationen. Ohne KI hätte die Einarbeitung in Notion deutlich länger gedauert; mit KI ließ sich vorhandene Fachexpertise effizient in eine funktionierende Architektur überführen.

KI ist jedoch kein Experte für Tool-Grenzen. Sie halluziniert plausible, aber nicht verfügbare Funktionen, verkennt praktische Abhängigkeiten und sieht Edge Cases nicht voraus. Das Formular-Beispiel zeigt die Fallhöhe: rhetorisch überzeugend, praktisch unbrauchbar.

Tragfähige Ergebnisse entstanden erst im Zusammenspiel aus drei Elementen: Fachexpertise für Inhalt und Prozesslogik (Phasen, Meilensteine, Aufgaben, Dauerrelationen), methodischer Rahmen mit Multi-Modell-Validierung, Resets und kritischem Gegenpart sowie KI als Beschleuniger für Strukturierung, Variantenbildung und Mikrotexte. Fehlt eines dieser Elemente, kippt das Ergebnis – entweder hübsch, aber inhaltlich schwach; technisch verspielt, aber unbrauchbar; oder langsam und fehleranfällig. Die richtige Frage lautet darum nicht, ob KI „es kann“, sondern wofür sie eingesetzt wird, wie Vorschläge validiert werden und welche Domänenkompetenz die Grundlage bildet.

Dos & Don’ts: Meine Erkenntnisse für KI-gestützte Tool-Entwicklung

Was sich bewährt hat: Ein präzises Agent-Setup mit klaren Zielen, Rollen und Constraints; kurze Iterationen mit regelmäßigen Resets; modellübergreifendes Arbeiten, um Perspektiven zu wechseln und Abkürzungen zu finden. Strukturierte Inputs – CSV-Exporte statt Freitext, Screenshots statt langen Layoutbeschreibungen – reduzieren Missverständnisse und Token-Ballast.

Ein kritischer Agent prüft konsequent Limitationen und Edge Cases, bevor Aufwand entsteht. Dokumentation der funktionierenden Formeln, wichtiger Entscheidungen und entdeckter Tool-Grenzen verhindert, dass dieselben Schleifen erneut gedreht werden. Fachexpertise bleibt der Kern: Sie entscheidet über Relevanz, Reihenfolge und Formulierungen – die KI übersetzt, beschleunigt und variiert.

Pausen gehören zum Prozess; Abstand verbessert Entscheidungen und reduziert technische Schuld.

Was nicht funktioniert: blindes Vertrauen in überzeugende Antworten; Umsetzungen ohne Vorabtest auf kleinem Scope; vage Prompts, die generische Lösungen erzeugen; Ein-Modell-Denken ohne Resets und Gegencheck; Big-Bang-Architektur, die Komplexität sprunghaft erhöht; die Illusion, Expertise sei durch KI obsolet. Der verlässliche Weg liegt zwischen Tempo und Sorgfalt: schnell genug, um Momentum zu halten, sorgfältig genug, um auf stabilem Fundament zu bauen.

Das Ergebnis: Was dabei herauskam

Das Template generiert aus Projektnamen, Start- und Enddatum einen individuellen Zeitplan mit allen – erweiterbaren – Phasen und Meilensteinen sowie 27 Aufgaben und rund 50 Unteraufgaben. Termine, Abhängigkeiten und Fortschritt werden automatisch berechnet und in einer Timeline visualisiert. Jede Aufgabe enthält Zweck, konkrete Handlungsschritte und Verweise auf passende Ressourcen – kein leeres Gerüst, sondern verdichtete Coaching-Erfahrung in einem sofort nutzbaren System. Zusätzlich entstanden eine schlanke, kostenlose Timeline-Variante ohne Aufgaben und ein Kanban-Board für agiles Arbeiten. Und das Beste: Das lässt sich anpassen und skalieren – auf so ziemlich alles, was einen Prozesscharakter hat. Jetzt, wo die Basis steht, folgen sicher noch andere Templates in Notion.

Fazit: KI verstehen, um KI zu nutzen

KI demokratisiert Expertise nicht automatisch. Sie hilft, vorhandenes Wissen in wirksame Formate zu übertragen – wenn Methodik, Validierung und klare Erwartungen den Rahmen setzen. In diesem Projekt machten präzise Agenten, strukturierte Inputs, Multi-Modell-Checks und ein kritischer Gegenpart den Unterschied.

Das Ergebnis ist ein Dashboard als robuster Fahrplan für die Abschlussarbeit; begleitend vermittelt ein Workshop, wie Notion und KI sinnvoll zusammenspielen. Entscheidend bleibt: KI ist ein Werkzeug. Wer seine Grenzen kennt und systematisch prüft, baut tragfähige Lösungen – nicht auf Sand.