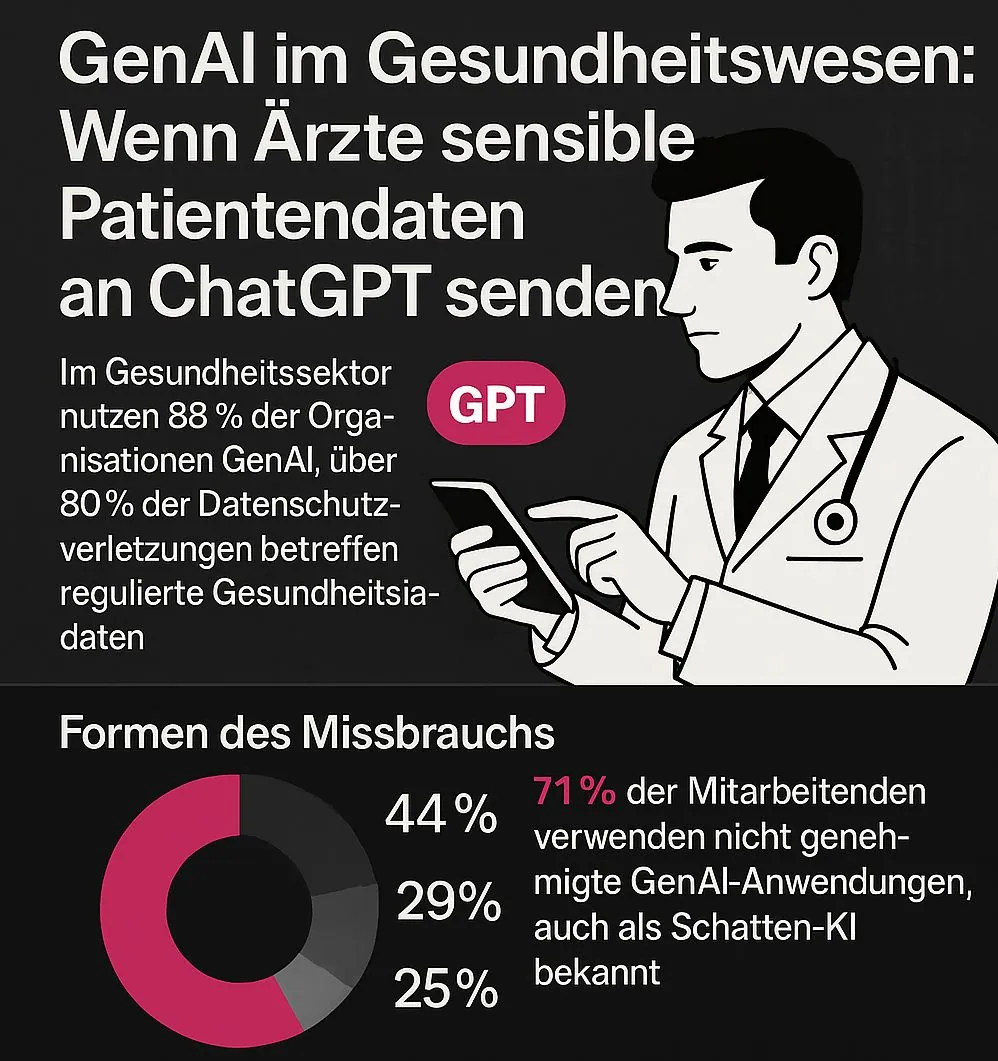

Die KI-Revolution im Gesundheitssektor hat ihre Schattenseiten: Wie eine aktuelle Studie von Netskope Threat Labs zeigt, landen erschreckend oft sensible Patientendaten in ChatGPT und Co. Während Kliniken die Effizienzvorteile generativer KI bejubeln, stehen Datenschützer vor einem Albtraum. Über 80 Prozent aller Datenschutzverstöße im Gesundheitswesen betreffen regulierte Gesundheitsdaten – und das in einer Zeit, in der 88 Prozent der Gesundheitsorganisationen GenAI nutzen.

Es klingt wie aus einem Datenschutz-Horrorfilm: Eine Ärztin kopiert schnell die Laborwerte samt Patientennamen in ChatGPT, um eine verständliche Erklärung für den Patienten zu generieren. Ein Pflegedienstleiter lädt Dienstpläne samt Personalnummern in sein persönliches Google Gemini-Konto hoch, um den nächsten Monatsplan zu optimieren. Der IT-Administrator eines Krankenhauses nutzt mal eben seinen privaten Microsoft OneDrive-Account, um Backups von Patientendaten zwischenzuspeichern.

Leider ist das keine dystopische Fiktion, sondern bittere Realität im deutschen und internationalen Gesundheitswesen. Eine brandneue Untersuchung von Netskope Threat Labs, veröffentlicht am 7. Mai 2025, bringt nun ans Licht, was viele Datenschutzbeauftragte längst befürchtet haben: Die GenAI im Gesundheitswesen wird zum massiven Sicherheitsrisiko für Patientendaten.

Die Zahlen sprechen eine erschreckend deutliche Sprache: 81 Prozent aller Verstöße gegen Datenrichtlinien in Gesundheitsorganisationen betrafen in den letzten zwölf Monaten regulierte Gesundheitsdaten. Also genau jene Daten, die durch Gesetze wie die DSGVO oder den US-amerikanischen HIPAA besonders geschützt sein sollten. Patientenakten, klinische Informationen, Gesundheitsdaten – alles landet in privaten Cloud-Speichern oder wird in KI-Tools wie ChatGPT eingegeben.

Die Zahlen sprechen eine erschreckend deutliche Sprache: 81 Prozent aller Verstöße gegen Datenrichtlinien in Gesundheitsorganisationen betrafen in den letzten zwölf Monaten regulierte Gesundheitsdaten. Also genau jene Daten, die durch Gesetze wie die DSGVO oder den US-amerikanischen HIPAA besonders geschützt sein sollten. Patientenakten, klinische Informationen, Gesundheitsdaten – alles landet in privaten Cloud-Speichern oder wird in KI-Tools wie ChatGPT eingegeben.

Doch damit nicht genug: Wie die Netskope-Analyse zeigt, ist GenAI im Gesundheitswesen mittlerweile allgegenwärtig. 88 Prozent der Organisationen setzen entsprechende Anwendungen ein – oft ohne ausreichende Sicherheitsmaßnahmen. Besonders erschreckend: Mehr als zwei von drei GenAI-Nutzern im Gesundheitswesen senden bei der Arbeit sensible Daten an ihre persönlichen KI-Konten.

| Art der Verstöße mit GenAI | Anteil |

| Regulierte Gesundheitsdaten | 44% |

| Quellcode | 29% |

| Geistiges Eigentum | 25% |

| Passwörter und Schlüssel | 2% |

„GenAI-Anwendungen bieten innovative Lösungen, führen aber auch neue Vektoren für potenzielle Datenschutzverletzungen ein, insbesondere in Umgebungen mit hohem Druck und hohen Risiken wie dem Gesundheitswesen, wo Mitarbeiter und Ärzte oft schnell und flexibel arbeiten müssen“, erklärt Gianpietro Cutolo, Cloud Threat Researcher bei Netskope Threat Labs, die Ergebnisse des Berichts.

Das Problem ist offensichtlich: Im hektischen Klinikalltag suchen Ärzte und Pflegepersonal nach schnellen Lösungen. Die Versuchung, mal eben ChatGPT zu nutzen, um eine komplizierte Diagnose zu übersetzen oder Google Gemini einen Behandlungsplan optimieren zu lassen, ist groß. Die Gefahr, dass dabei sensible Daten in die falschen Hände geraten, wird in der Eile oft übersehen.

Ein besonders brisantes Phänomen ist die sogenannte „Schatten-KI“ – die Nutzung nicht genehmigter KI-Tools durch Mitarbeiter. Obwohl dieser Trend rückläufig ist (von 87% auf 71% im letzten Jahr), bleibt er ein massives Problem. Mitarbeiter greifen aus Bequemlichkeit, Unwissenheit oder aus Effizienzgründen auf ihre privaten GenAI-Accounts zurück, ohne die Sicherheitsrisiken zu bedenken.

Das Problem verschärft sich noch durch die Tatsache, dass 96% der eingesetzten Anwendungen Nutzerdaten für Trainings verwenden und 98% der Gesundheitsorganisationen Apps mit GenAI-Funktionen einsetzen. Diese Kombination schafft einen gefährlichen Mix aus Datenhunger und mangelnder Kontrolle.

Doch es gibt Hoffnung. Kluge Gesundheitsorganisationen setzen bereits auf mehrschichtige Sicherheitskonzepte, um die Vorteile der GenAI im Gesundheitswesen zu nutzen, ohne Patientendaten zu gefährden:

Ein Vorzeigebeispiel für einen gelungenen Spagat zwischen Innovation und Sicherheit ist die Klinikum Magdeburg GmbH. „Als Krankenhaus sind wir Teil der kritischen Infrastruktur. Damit tragen wir eine besondere Verantwortung für den Schutz sensibler Daten und die IT-Sicherheit“, erläutert Tobias Hunger, Abteilungsleiter Informations- und Medizintechnik & Certified Healthcare CIO der Klinik.

Die Magdeburger haben moderne Cloud-Technologien und GenAI-Anwendungen im Gesundheitswesen bereits erfolgreich in viele Prozesse und Arbeitsabläufe integriert – allerdings mit einem ganzheitlichen Sicherheitskonzept, das technologische Innovation, rechtliche Compliance und IT-Sicherheit systematisch miteinander verbindet.

Die gute Nachricht: Es gibt Fortschritte. Immer mehr Gesundheitsorganisationen erkennen die Risiken und implementieren Gegenmaßnahmen. Der Anteil der Kliniken mit DLP-Richtlinien für GenAI ist im letzten Jahr von 31% auf 54% gestiegen, und die Nutzung persönlicher GenAI-Konten ging von 87% auf 71% zurück.

Doch wie so oft hinkt die Sicherheit der technologischen Entwicklung hinterher. „Im Gesundheitswesen haben die rasche Einführung von GenAI-Apps und die zunehmende Nutzung von Cloud-Plattformen dem Schutz regulierter Gesundheitsdaten neue Dringlichkeit verliehen“, warnt Gianpietro Cutolo. „Da GenAI immer stärker in klinische und betriebliche Arbeitsabläufe eingebettet wird, beschleunigen Organisationen die Einführung von Kontrollen wie DLP und App-Blockierungsrichtlinien, um Risiken zu verringern.“

Die entscheidende Frage bleibt: Wer trägt letztendlich die Verantwortung für Datenpannen durch GenAI im Gesundheitswesen? Sind es die überarbeiteten Ärzte, die in bester Absicht ChatGPT konsultieren? Die IT-Abteilungen, die sichere Alternativen bereitstellen müssen? Oder die Klinikleitung, die klare Richtlinien definieren und durchsetzen sollte?

Die Antwort ist – wie so oft im komplexen Gesundheitssystem – nicht einfach. Es braucht eine Kombination aus:

Die Netskope-Studie macht eines überdeutlich: GenAI im Gesundheitswesen ist ein zweischneidiges Schwert. Einerseits bietet sie enorme Chancen für effizientere Diagnosen, personalisierte Behandlung und Entlastung des Personals. Andererseits schafft sie ohne entsprechende Sicherheitsmaßnahmen ein erhebliches Risiko für Patientendaten.

Der Weg in die Zukunft kann nur über sichere, für Unternehmen zugelassene Lösungen führen. Kliniken müssen ihre Mitarbeiter nicht nur mit den richtigen Tools ausstatten, sondern auch die nötige Sensibilität für den Umgang mit sensiblen Daten schaffen. Nur so kann das volle Potenzial der GenAI im Gesundheitssektor ausgeschöpft werden, ohne Patienten oder Organisationen zu gefährden.

Letztendlich geht es nicht darum, die KI-Revolution im Gesundheitswesen zu stoppen – sondern sie in sichere Bahnen zu lenken. Denn eines ist klar: Die GenAI wird bleiben und weiter an Bedeutung gewinnen. Die Frage ist nur, ob wir ihre Vorteile nutzen können, ohne dabei die Privatsphäre der Patienten zu opfern.

Und seien wir ehrlich: Würden Sie wollen, dass Ihre persönlichen Gesundheitsdaten in den Trainingsdaten des nächsten ChatGPT-Updates landen?

Um Ihnen ein optimales Erlebnis zu bieten, verwenden wir Technologien wie Cookies, um Geräteinformationen zu speichern und/oder darauf zuzugreifen. Wenn Sie diesen Technologien zustimmen, können wir Daten wie Ihr Surfverhalten oder eindeutige IDs auf dieser Website verarbeiten. Wenn Sie Ihre Zustimmung nicht erteilen oder widerrufen, können bestimmte Merkmale und Funktionen beeinträchtigt werden.